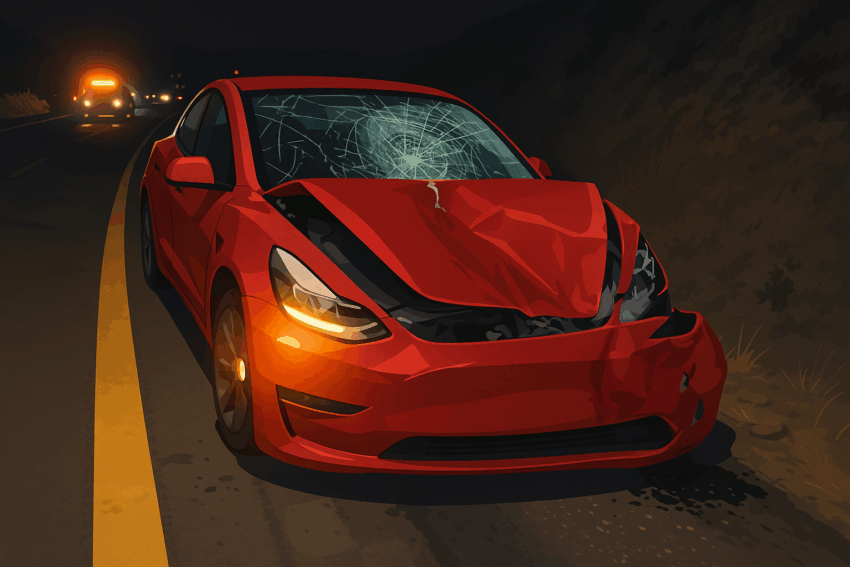

Một vụ tai nạn – Một lời cảnh tỉnh cho công nghệ xe tự lái

Tháng 11/2023, tại bang Arizona (Mỹ), một vụ tai nạn nghiêm trọng liên quan đến chiếc Tesla Model Y đang sử dụng chế độ Tự lái hoàn toàn (Full Self-Driving – FSD) đã khiến một người phụ nữ 71 tuổi thiệt mạng tại chỗ

1.

Camera trên xe ghi lại toàn bộ khoảnh khắc chiếc Tesla lao vào người đi bộ với tốc độ cao, trong khi hệ thống FSD đang hoạt động. Đây là trường hợp tử vong đầu tiên của người đi bộ được ghi nhận có liên quan đến công nghệ tự lái của Tesla

1.

Công nghệ chưa hoàn thiện – Rủi ro vẫn hiện hữu

Dù được quảng bá là “tự lái hoàn toàn”, hệ thống FSD của Tesla vẫn yêu cầu người lái giám sát liên tục. Tuy nhiên, thực tế cho thấy:

- Người dùng vẫn có thể lơ là hoặc hiểu sai về khả năng của xe.

- Hệ thống chưa đủ khả năng xử lý các tình huống giao thông phức tạp, như ánh sáng chói, vật thể bất ngờ, hay người đi bộ không đúng làn.

Các chuyên gia cho rằng Tesla đang triển khai công nghệ quá sớm, khi mà bằng chứng cho thấy hệ thống vẫn chưa đạt mức an toàn cần thiết

1.

Tesla và cuộc điều tra liên bang

Sau vụ tai nạn, Cơ quan An toàn Giao thông Đường bộ Quốc gia Mỹ (NHTSA) đã mở cuộc điều tra về tính an toàn của hệ thống FSD. Trước đó, Tesla cũng đã phải thu hồi hơn 2 triệu xe để cập nhật phần mềm Autopilot sau hàng loạt vụ va chạm

1.

Giới hạn của “tự lái hoàn toàn” là gì?

Dù Elon Musk từng tuyên bố xe Tesla có thể tự lái mà không cần người điều khiển, thực tế cho thấy:

- FSD chỉ là hệ thống hỗ trợ lái nâng cao, chưa đạt cấp độ tự hành hoàn toàn (Level 5).

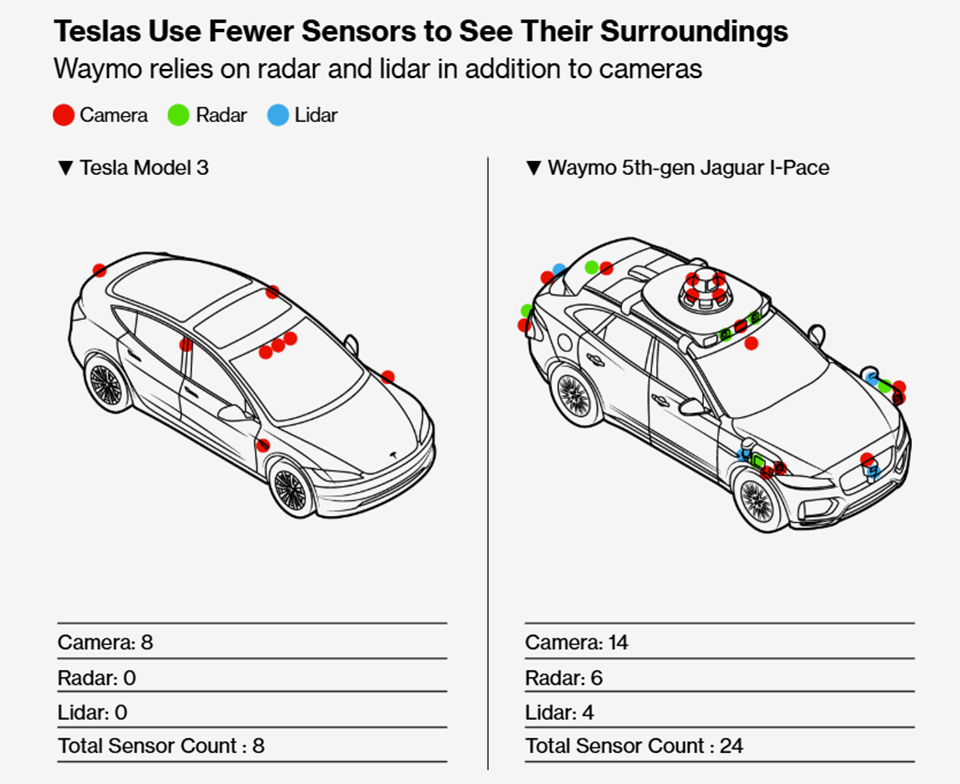

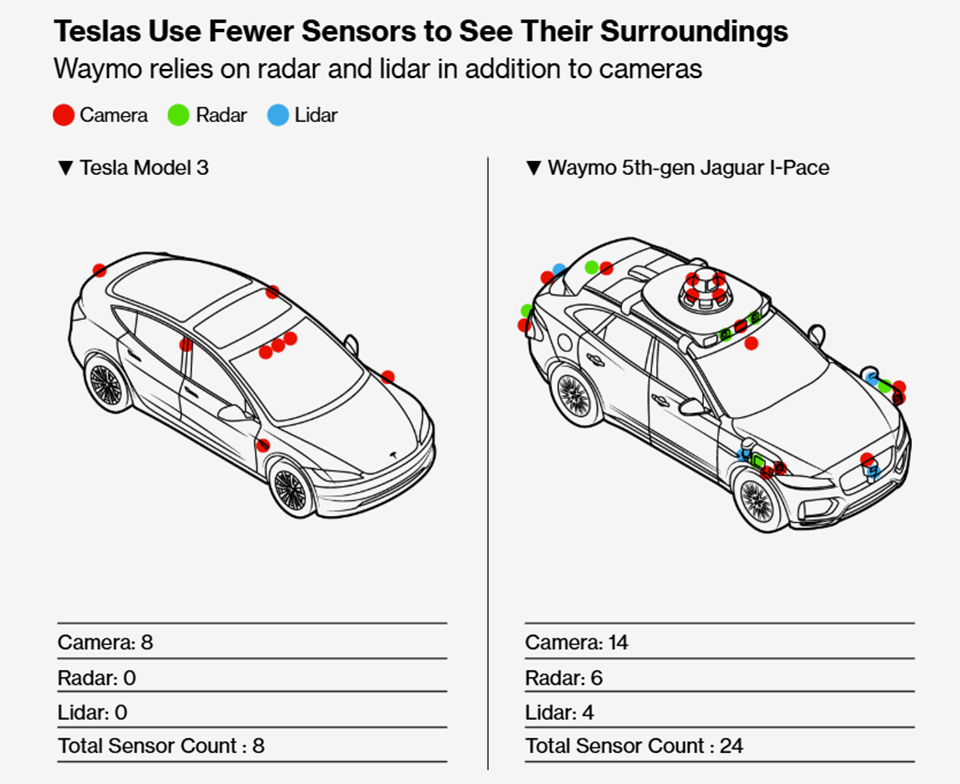

- Xe vẫn phụ thuộc vào camera và AI, không sử dụng cảm biến lidar như các đối thủ như Waymo.

- Sai sót nhỏ trong nhận diện vật thể có thể dẫn đến hậu quả nghiêm trọng.

Kết luận: Công nghệ cần thời gian – An toàn là ưu tiên

Vụ tai nạn chết người của Tesla là lời nhắc nhở mạnh mẽ rằng công nghệ tự lái vẫn còn giới hạn. Trong khi tương lai xe tự hành là điều không thể tránh khỏi, sự an toàn của con người phải là ưu tiên hàng đầu.